Um ein perfektes Produkt mit der Programmiersprache Java zu erstellen braucht es eine gründliche Qualitätskontrolle und methodisches Vorgehen.

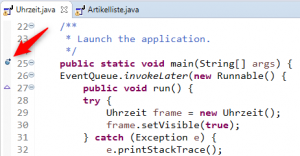

Der Entwickler unterscheidet, ob ein logischer Fehler oder ein Schreibfehler vorliegt. Logische Fehler können mit Hilfe einer genauen Beschreibung des Produkts oder Vorgangs durch Soll-Ist Vergleiche erkannt und beseitigt werden. Manchmal wäre es praktisch, wenn ein Programm zum Test Schritt für Schritt ausgeführt werden könnte und dabei die Werte der Variablen, Übergabeparameter und Attribute auslesen kann. Hier kann die Java Entwicklungsumgebung Eclipse durch den integrierten Debugger unterstützen. Durch setzen eines Breakpoints, einer temporären Haltestelle, können die gewünschten Werte geprüft werden. Das setzen des Breakpoints erzeugt einen kleinen blauen Punkt auf der linken Seite. Durch erneutes Klicken mit der Maus auf diesen Punkt wird der Breakpoint wieder entfernt.

Mit der Taste F11 wird der Debugger in Eclipse gestartet. Bei Punkt 1 wird die Breakpoint Markierung und der Java Quellcode angezeigt. Bei dem rechten Fenster werden bei Punkt 2 die Breakpoints und nach dem klicken auf einen Breakpoint werden unten weitere Informationen angezeigt. Auf der linken Seite bei Punkt 3 die Aufrufhierarchie angezeigt.

Für die weitere Bearbeitung stehen weitere Funktionen zur Verfügung

- F5 Step into

Es können Methoden aufgerufen und in der ersten Zeile angehalten werden. Ansonsten wird der Debugger bis zum nächsten Methodenaufruf weiterlaufen. - F7 Step Return

Mit Step Return kann der Sprung in eine Methode durch Step Into zurückgenommen werden und an der vorherigen Haltestelle wieder weiter analysiert werden. - F6 Step Over

Step Over kann einen zu analysierenden Bereich überspringen. - F8 Resume

Das Programm wird bis zum nächsten Breakpoint ausgeführt. - CTRL+R Run To Line

Die Ausführung des Programms wird bis zu einer bestimmten Zeile durchgeführt. - CTRL+F2 Terminate

Die Ausführung des Programms wird beendet.

Mit dem Debugger lassen sich während des Probelaufs eines Programms die Variablen, Schleifen, Abfragen, Methodenaufrufe beobachten und so können Fehler leichter gefunden werden.