XML oder ausgeschrieben Extended Markup Language ist eine Metasprache mit der Daten strukturiert beschrieben werden können. XML hat sich aus der Ende der 1960-er Jahre erfundenen Metasprache SGML weiter entwickelt. Mit XML wird die Struktur, der Inhalt und die Darstellung der Daten getrennt. Dadurch lassen sich die 3 Teilbereiche unabhängig voneinander verarbeiten. Auch die millionfach eingesetzte Auszeichnungssprache HTML basiert auf XML und SGML.

Bei der KI dient diese Sprache zur Kommunikation zwischen Anwendungen und Maschinen. So spielt XML eine immer wichtigere Rolle bei der Maschine zu Maschine Kommunikation und wird zudem bei Konfigurationen von IOT Geräten eingesetzt.

Definition von Dokumentklassen

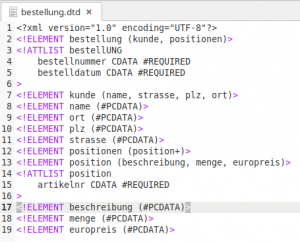

Bevor Daten übertragen werden können, erfolgt die Deklaration der XML-Elemente. Dazu gibt es zwei Möglichkeiten zur Erstellung von Dokumentklassen und Elementen.

- Mit DTD, der Document Type Definition lassen sich die Dokumentklassen und Elemente definieren.

- Die zweite und modernere Methode ist das XML Schema.

Struktur der XML Dokumente

Die Dokumenttyp Definition

Oder alternativ das XML Schema

Das XML Dokument mit den strukturierten Daten

Das XML Dokument nutzt im Dokumentenkopf entweder das XML Schema oder den DTD. Die Elemente von XML werden auch Tags oder Nodes genannt.

Vorteile von XML

- Als Konfigurationsdateien bleiben die Daten für den Menschen lesbar

- Über Schnittstellen und Webservices wie SOAP und REST lassen sich Daten systemübergreifend austauschen

- Die Dateien lassen sich mit jedem Texteditor öffnen und bearbeiten

- Mit Hilfe von CSS oder XSLT lassen sich die Daten transformieren und so unterschiedlich nutzen.